- 역할극·톤 전환·출력 제약… ‘숨겨진 코드’로 포장된 프롬프트 기술을 사례로 해부하다

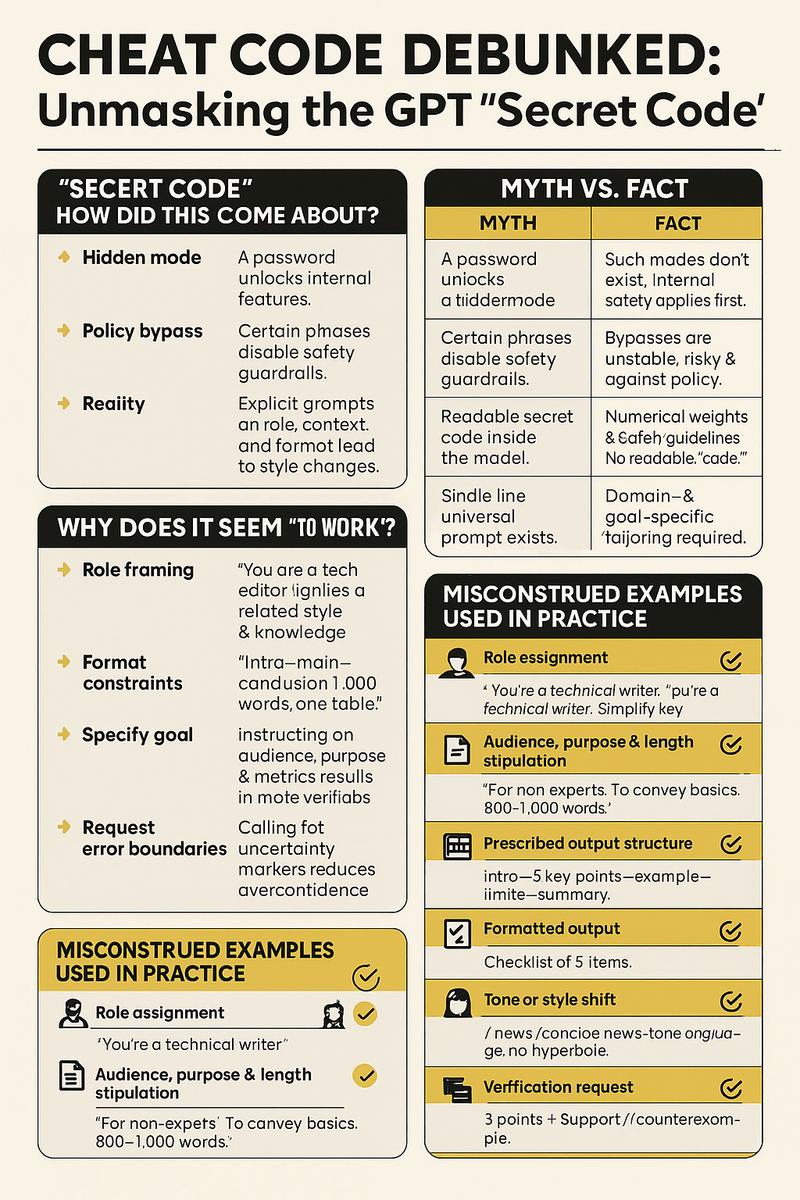

인포그래픽=기사 내용의 이해를 돕기 위한 AI 이미지

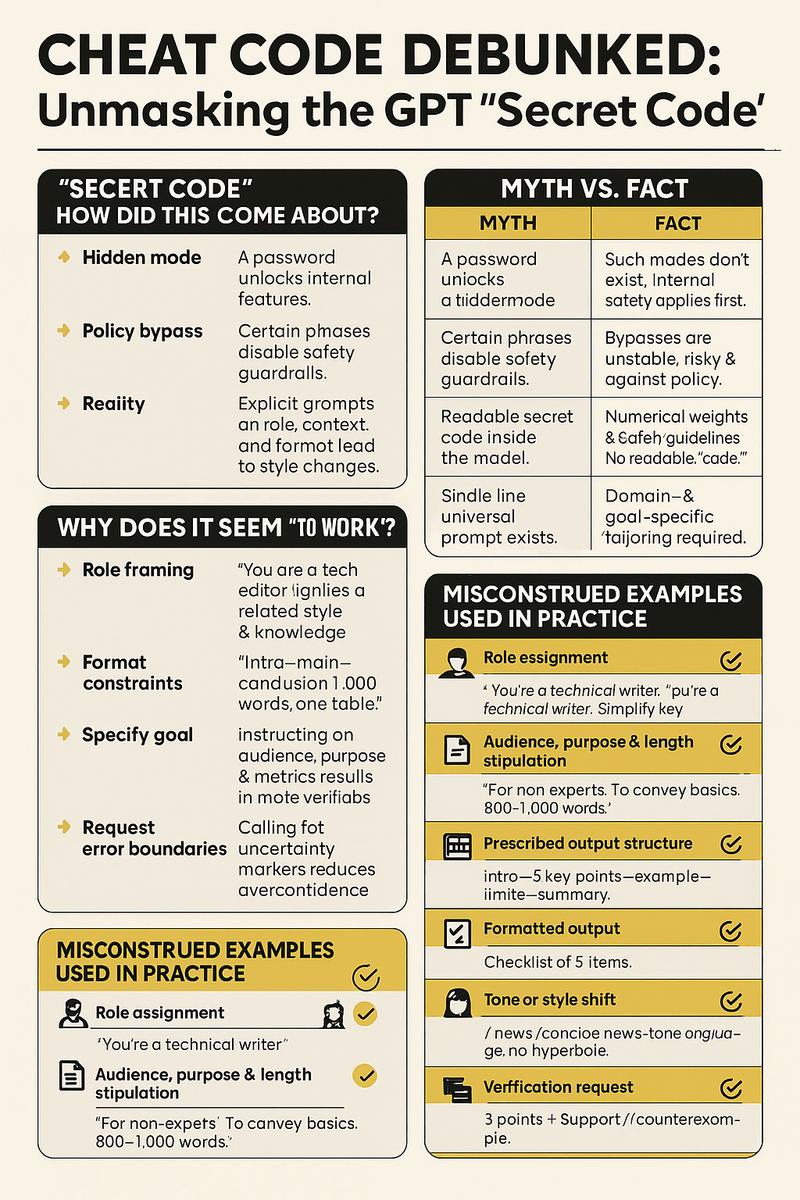

인포그래픽=기사 내용의 이해를 돕기 위한 AI 이미지

“몇 글자만 입력하면 GPT가 잠금 해제된다?” 온라인에선 이른바 ‘GPT 비밀 코드’ 소문이 꾸준히 돌았다. 그러나 전문가와 업계 취재를 종합하면 결론은 간명하다. 치트키는 없다. 다만 사람들은 **프롬프트 설계(역할·맥락·형식 지시)**로 생기는 스타일 변화를 ‘비밀 코드’로 오해해왔다.

‘비밀 코드’라는 말은 어떻게 생겼나

오해 1|숨겨진 모드: “암호를 입력하면 내부 기능이 열린다”는 서사.

오해 2|정책 우회: 특정 문구로 안전장치가 꺼진다는 믿음.

현실|확률적 언어 모델: GPT는 다음 단어를 예측하는 모델이다. 사용자가 역할, 목표, 형식을 또렷이 지시하면 출력이 바뀌며, 이것이 마치 ‘비밀 기능’처럼 느껴진다. 하지만 안전 규칙과 시스템 지침은 항상 우선 적용된다.

왜 ‘먹히는 것처럼’ 보일까

역할 프레이밍 효과: “너는 기술 에디터야”처럼 역할을 주면 관련 문체·지식이 활성화된다.

형식 제약의 힘: “서론–본론–결론, 길이 1,000자, 표 1개” 등 명시적 제약이 품질을 안정화한다.

목표의 구체화: 독자·목적·평가 기준을 적어두면 모델이 평가 가능 출력을 만든다.

오류 경계 요청: 한계·불확실성 표기를 요구하면 과장·환각을 줄인다.

사례로 보는 ‘비밀 코드’ 오해 vs. 실전 활용

아래는 ‘비밀 코드’로 포장되곤 했지만, 실제로는 합법적 프롬프트 설계에 불과한 패턴들이다. 각 항목에 안전한 예시를 덧붙였다.

역할 지정(예: 전문 편집자)

독자·목적·분량 규정

출력 구조 고정(템플릿)

형식화된 결과물(JSON/표/체크리스트)

톤·스타일 전환(공식 명령어 아님)

검증 요구(근거·반례 병기)

불확실성 표기 의무화

요약 우선 원칙

금지·허용 범위 사전 명시

검토 루프(HITL) 내장

주의: 온라인에서 회자되는 ‘DAN’이나 ‘개발자 모드’ 같은 탈옥(Jailbreak) 캐릭터 놀이는 안전장치를 우회하려는 시도로 분류되며, 정책 위반 위험이 크다. 안정성·윤리·법적 리스크 때문에 추천되지 않는다.

팩트체크: Myth vs. Fact

주장(미신) | 사실(팩트) |

|---|

“암호를 입력하면 숨겨진 모드가 열린다” | 그런 모드는 존재하지 않는다. 내부 안전 규칙은 항상 우선한다. |

“특정 문구로 안전장치를 끌 수 있다” | 우회 불가. 시도하더라도 불안정·위험·정책 위반 소지. |

“모델 안에 사람이 읽을 비밀 코드가 있다” | 내부는 수치 가중치와 안전 지침. 사람이 읽는 ‘코드’가 아니다. |

“만능 한 줄 프롬프트가 있다” | 도메인·목표별 맞춤 설계가 필요하다. 만능은 없다. |

위험과 리스크: 왜 ‘비밀 코드’ 놀이가 문제인가

정책·윤리 위반: 유해·불법·저작권 침해 유도 위험

허위정보(환각) 증폭: 권위적 어조가 오판을 부를 수 있음

프롬프트 인젝션: 외부 텍스트의 숨은 지시가 모델 행동을 오염

데이터 유출: 민감 정보가 프롬프트에 섞여 외부로 노출될 수 있음

감사·규제 대응 실패: 기록·출처·동의 체계를 무시하면 컴플라이언스 리스크

독자를 위한 ‘안전 프롬프트’ 미니 가이드(실전형)

목표·독자·형식을 한 줄로: “초보 개발자 대상, 개념 이해 목적, 700자 요약.”

역할을 명확히: “너는 기술 사전 편집자.”

구조를 고정: “개요–핵심 요점–예시–한계–요약.”

검증을 요구: “주장 3개+근거/반례, 마지막에 체크리스트.”

한계 표시: “불확실하면 불확실로 표기하고 확인 절차 제시.”

‘GPT 비밀 코드’라는 말은 프롬프트 설계가 만드는 스타일 변화를 과장한 신화일 뿐이다. 치트키는 없다.

대신 역할·목표·형식·검증을 갖춘 좋은 프롬프트가 있다. 안전 규칙과 거버넌스를 존중하는 방식으로 활용할 때, 우리는 ‘비밀 코드’ 없이도 충분히 강력하고 신뢰할 수 있는 결과를 얻을 수 있다.

AI 리서치 컨설턴트의 한 줄

“비밀”을 찾기보다 문제 정의와 검증 루프에 시간을 쓰는 것이, AI를 잘 쓰는 가장 빠른 길이다.

(더욱 상세한 내용은 책 "AI, 넥스트 프론티어"를 참고하기 바랍니다.)

AI 혁신 물결: xAI의 세계 모델, OpenAI GPT-5 업데이트, Hugging Face 오픈소스 NLP 모델 출시

2025년 말, AI 분야에서 주요 기업들의 연이은 발표가 이어지며 기술 발전의 속도가 가속화되고 있다. xAI의 로보틱스용 물리 세계 이해 모델 개발, OpenAI의 GPT-5 시리즈 업데이트, 그리고 Hugging Face의 맞춤형 NLP 오픈소스 모델 출시가 그 중심에 있다. 이러한 발전은 로보틱스, 자연어 처리, 콘텐츠 생성 등 다양한 영역에서 실용적 적용을 촉진할 ...

AI 혁신 물결: xAI의 세계 모델, OpenAI GPT-5 업데이트, Hugging Face 오픈소스 NLP 모델 출시

2025년 말, AI 분야에서 주요 기업들의 연이은 발표가 이어지며 기술 발전의 속도가 가속화되고 있다. xAI의 로보틱스용 물리 세계 이해 모델 개발, OpenAI의 GPT-5 시리즈 업데이트, 그리고 Hugging Face의 맞춤형 NLP 오픈소스 모델 출시가 그 중심에 있다. 이러한 발전은 로보틱스, 자연어 처리, 콘텐츠 생성 등 다양한 영역에서 실용적 적용을 촉진할 ...

서울국제조각페스타 2026, 코엑스서 예술과 기업의 만남 성황

서울국제조각페스타 2026, 코엑스서 예술과 기업의 만남 성황

[손현식 칼럼] 270만 외국인 시대, ‘함께 사는 법’은 배운 적이 없다

[손현식 칼럼] 270만 외국인 시대, ‘함께 사는 법’은 배운 적이 없다

할리우드 배우노조, 스튜디오 측에 새 반대 제안 테이블에 올리다

할리우드 배우노조, 스튜디오 측에 새 반대 제안 테이블에 올리다

하나님의 축복 속에서 시작된 사랑… 특별한 결혼의 여정

하나님의 축복 속에서 시작된 사랑… 특별한 결혼의 여정

목록

목록